ChatGPT verstehen: Von der Transformer-Architektur zu Business Modellen generativer KIs

Künstliche Intelligenz (KI) gehört zu unserem Alltag und erleichtert ihn durch Sprachsteuerung, beim Einparken oder Saugen. ChatGPT ist ein Beispiel dafür, wie KI unser Leben bereichern und vereinfachen kann. Ob es darum geht, den Kundenservice zu verbessern oder neue Anwendungen für die Texterstellung zu entwickeln – KI-Sprachmodelle haben das Potenzial, einen tiefgreifenden Einfluss auf den Unternehmensalltag auszuüben.

Welche Business Modelle daraus entstehen können und wie die Transformer-Technologie hinter ChatGPT funktioniert, nehmen wir in dieser Podcast-Folge genauer unter die Lupe.

Im Gespräch mit Frank Schönefeld

Den ersten Kontakt mit ChatGPT hatte Frank Schönefeld bereits 2020 im Rahmen einer Projektarbeit. Die teilnehmenden Studierenden programmierten damals mithilfe der Version 2.0 des Textgenerators ein sprachbasiertes Schachspiel.

2022 begleitete er eine KI-Weltpremiere an der Semperoper Dresden. Für das cross-mediale Opern-Projekt „chasing waterfalls“ vom Performing Arts Künstlerkollektiv phase7 haben wir als Kooperationspartner eine Gesangsstimme auf Basis von künstlicher Intelligenz entwickelt.

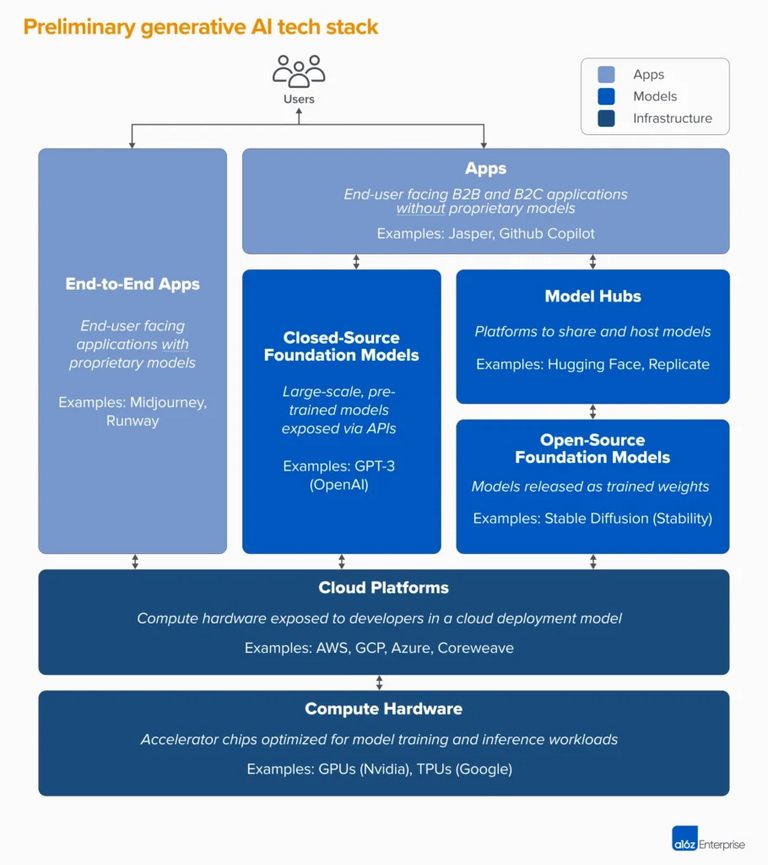

Die Profiteure der Technologie: Infrastrukturanbieter statt Business-Modelle

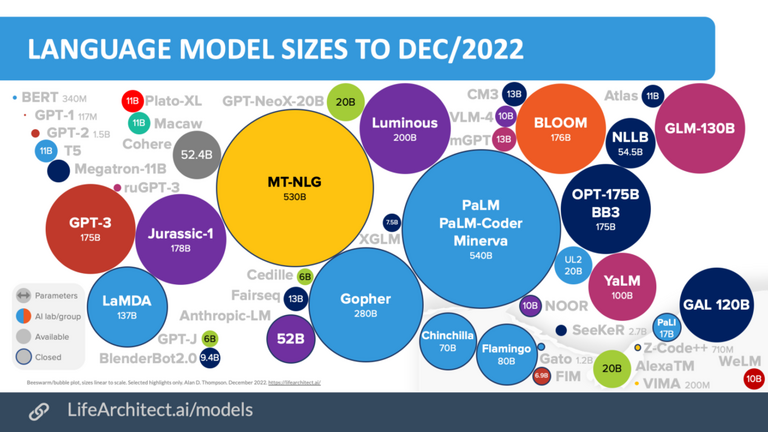

GPT steht für „Generative Pretrained Transformer“. Die dritte Version des Textgenerators (GPT-3) wurde von OpenAI im November 2022 veröffentlicht. Wie der Name bereits andeutet, ist ChatGPT ein textbasiertes Dialogsystem, das in Messenger-Optik präsentiert wird und menschenähnliche Konversationen führen kann. Die Transformer-Architektur von ChatGPT ist eine der fortschrittlichsten Technologien im Bereich der KI. Sie ermöglicht es menschenähnliche Konversationen zu führen, indem es Fragen versteht und passende Antworten generiert. Die Technologie basiert auf einem Deep Learning-Ansatz, bei dem der Chatbot mit enormen Mengen an Texten trainiert wurde, um ein Verständnis für die Sprache zu entwickeln. Laut einem Paper der Nvidia und der Stanford University würde das Training von GPT-3 mit 175 Milliarden Parametern mithilfe eines Prozessors der Version V100 NVIDIA GPU einen Zeitraum von 288 Jahren in Anspruch nehmen. Damit die Trainingszeit des Large Language Models (LLM) verkürzt werden kann, wird eine entsprechende Anzahl an Prozessoren benötigt. Hier wird sehr schnell deutlich, dass die eigentlichen Profiteure der Technologie derzeit noch nicht die auf der Technologie aufbauenden Business Modelle sind, sondern die Infrastrukturanbieter, deren Hardware benötigt wird, um eine leistungsstarke KI mit einer ausreichend großen Datenmenge zu trainieren.

Open Source-Alternativen für ChatGPT

Als LLM ist ChatGPT von zahlreichen Wettbewerbern im Markt umgeben. Zu den bekanntesten zählen der PaLM-Coder Minerva von Google und MT-NLG von Microsoft und Nvidia. Während die beiden genannten Beispiele der Big Player in der Technologieindustrie für die Allgemeinheit nicht frei zugänglich sind, gibt es gleichzeitig eine wachsende Zahl an Open Source-Alternativen. Hier haben Entwickler*innen Zugang zu den Quellcodes und können die Technologie an die eigenen Bedarfe anpassen. Ein Beispiel hierfür ist die Plattform „Transformers“ von Hugging Face, eine Open Source-Bibliothek, die es Entwickler*innen ermöglicht, die neuesten Transformer-Modelle wie bspw. BLOOM, für Natural-Language-Processing-Aufgaben zu nutzen. Ein weiteres LLM im Open Source-Universum ist Jurassic-1 von AI21 Studio.

Diese Open Source-Ansätze bieten eine große Chance für Forscher*innen und Entwickler*innen, neue Anwendungen und Technologien im Bereich der KI zu entwickeln und zu verbessern. Denn trotz aller Begeisterung anlässlich OpenAIs Veröffentlichung von ChatGPT – absolut fehlerfrei und makellos funktionieren die Textgeneratoren bisher noch nicht. Schon nach der Anmeldung weist OpenAI die Anwender*innen von ChatGPT auf einen eigenverantwortlichen und achtsamen Umgang mit der Technologie hin und schließt Fehlinformationen oder möglicherweise auftretende diskriminierende Inhalte nicht aus.

Natürlich müssen wir auch selbst aufpassen, nicht bedingungslos den Antworten [einer KI] zu vertrauen. Und das ist im Moment noch eine der großen Schwächen der Language Models – dass sie nicht zwischen Fiktion und faktischer Wahrheit unterscheiden können. Frank Schönefeld, CTO | Telekom MMS

Die große Schwäche von Large Language Models

Die Nutzung von KI ist folglich mit einigen Risiken verbunden, vor denen Expert*innen warnen. Beispielsweise kann es zur Reproduktion von Vorurteilen kommen, wenn diskriminierende Quellen in die Datensätze einfließen, auf deren Basis die KI lernt. Um den Fehler zu beheben, wird die Datenbasis gesucht. Wenn die Quelle jedoch nicht auffindbar ist, kann der Fehler nicht behoben werden. Dieses Problem tritt vor allem bei sogenannten generativen KIs auf, deren Modelle auf genau diesen riesig-großen Large Language Models basieren, wie auch die beiden aktuell heißdiskutierten Tools von OpenAI: ChatGPT zur Texterstellung oder DALL-E für Bildgenerierungen.

Zusammen mit der Datenschutz-Grundverordnung (DSGVO) soll der AI Act zur Sicherheit und ethischen Vertretbarkeit von KI beitragen. Damit für den Umgang mit KI in Übereinstimmung mit europäischen Werten und technologischem Fortschritt ein einheitliches Gesetz in der EU gültig ist, soll der AI Act 2024 in Kraft treten. Insgesamt wäre er in 27 Ländern und für über 447 Millionen Menschen rechtskräftig und somit auch für Unternehmen relevant.

Was der AI Act für den Umgang mit Künstlicher Intelligenz bedeutet

Mit dem AI Act werden Vorschriften für die Entwicklung, Einführung und Nutzung von KI vorgegeben und Risikobewertungen festgelegt, durch die es zu Einschränkungen und Verboten kommt. Der Einsatz von KI ist nur in den Fällen erlaubt, in denen kein hohes Risiko für die menschliche Gesundheit oder Sicherheit besteht und keine Grundrechte verletzt werden. KI-Systeme, die mit einem hohen Risiko eingestuft werden, sollen laut AI Act eingeschränkt und im Rahmen eines Risikomanagementsystems überwacht werden. Bei einem geringen oder keinem Risiko, ist der Einsatz von KI uneingeschränkt erlaubt.

Wie können sich Unternehmen also auf den AI Act vorbereiten?

- Wissen aneignen: Es ist essenziell sich Wissen rund um KI und den AI Act anzueignen und die Mitarbeitenden zu informieren, wo sie KI im Arbeitsalltag begleitet und im Unternehmen angewendet wird. Dabei ist auch eine Aufklärung über die Vorteile und Risiken wichtig.

- Das Richtige Mindset schaffen: Durch die Entwicklung einer digitalen Unternehmensstrategie (CDR) und der nachhaltigen Integration in die Prozesse wird das Vertrauen in KI gefördert.

- Fakten schaffen und Transparenz zeigen: Durch Fakten kann der Mehrwert demonstriert werden, den Technologie für den Menschen hat und das Vertrauen gefördert werden. Dabei helfen Indikatoren, wie die Anzahl der erfolgreich abgewehrten Phishing-Angriffe durch KI-basierte Anwendungen oder die Summe der so entdeckten Anomalien.

- Interdisziplinarität aufbauen: Der Umgang mit KI geht über die IT-Verantwortung hinaus und ist vor allem im Data-Privacy-Management und Risikomanagement einzuordnen. Unternehmen sollten abteilungs- und funktionsübergreifende Arbeitskreise bilden (IT-Fachleute, Jurist*innen, Risikomanagement und Datenschutzverantwortliche), um alle Aspekte der Verordnung abzudecken.

- Zertifizieren nach Qualitätsstandards: Es gibt zahlreiche Qualitätsstandards, die eine Softwareentwicklung nach datenschutztechnischen und ethischen Kriterien erleichtern. Ein unternehmensinternes Privacy-and-Security-Assessment-Verfahren (PSA-Verfahren) kann eine sichere und faire System- und Produktentwicklung unterstützen.

Wie genau die Transformer-Technologie hinter ChatGPT funktioniert und welche Rolle hierbei Stromverbrauch und Nachhaltigkeit spielen, hören Sie in der aktuellen Podcastfolge von „Ausgesprochen digital“.

Moderiert wird diese Folge von Steffen Wenzel, Mitgründer und Geschäftsführer von politik-digital.

Hinweis:

Unseren aufmerksamen Podcastfans ist sicherlich aufgefallen, dass Frank Schönefeld zwei Details nicht ganz korrekt oder unvollständig bezeichnet hat:

- Selbstverständlich ist nicht die „TU München“, sondern die „LMU München“ gemeint.

- Ergänzend zur Erklärung der Transformer-Technologie ist zu erwähnen, dass ChatGPT lediglich mit der Decoder-Funktion arbeitet.

Ausgesprochen Digital bei:

Neugierig auf die weiteren Themen?